爬虫是每个AI爱好者的必备软件,无论你做哪种AI都离不开数据,Gpt-crawler 是版主非常推荐的,利好新手,安装简单,只需要花10几分钟时间就可以开始你的抓取任命了,让我们开始今天的教程。

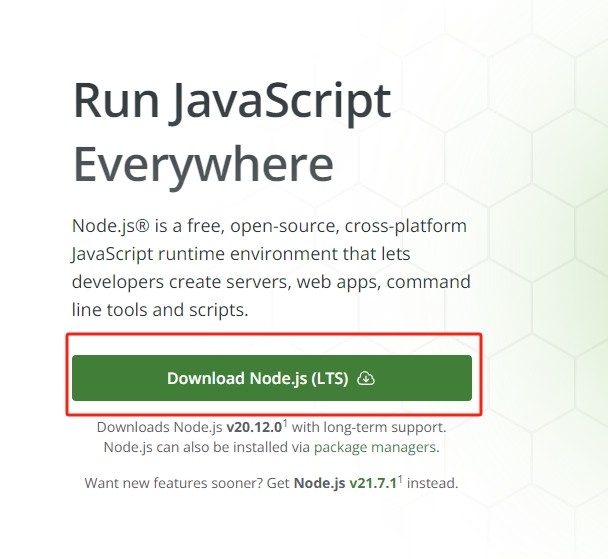

安装NOde.JS

打开node官网,https://nodejs.org/en 。点击donload ,下载下来之后点击下一步下一步就可以了。

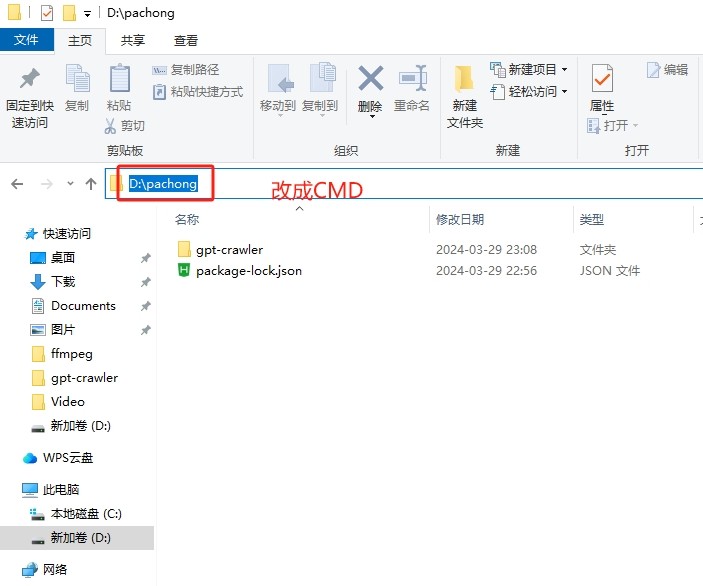

安装Gpt-crawler

在你想安装的电脑盘里 建立一个文件夹 比如就叫 Gpt-crawler 然后在这个文件夹的路径上输入CMD

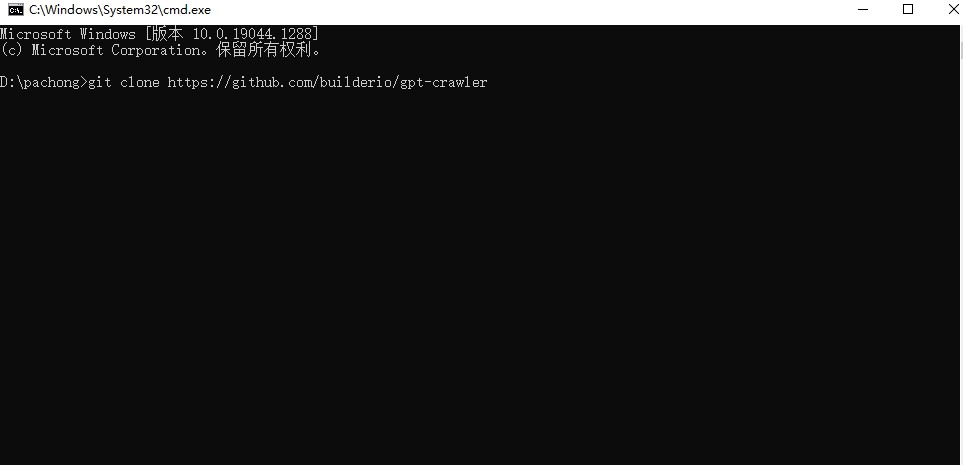

输入安装指令安装主程序:git clone https://github.com/builderio/gpt-crawler

安装完以后进入这个文件夹 输入 cd gpt-crawler

进入这个文件夹之后 输入安装依赖项命令:npm i

至此安装完成。

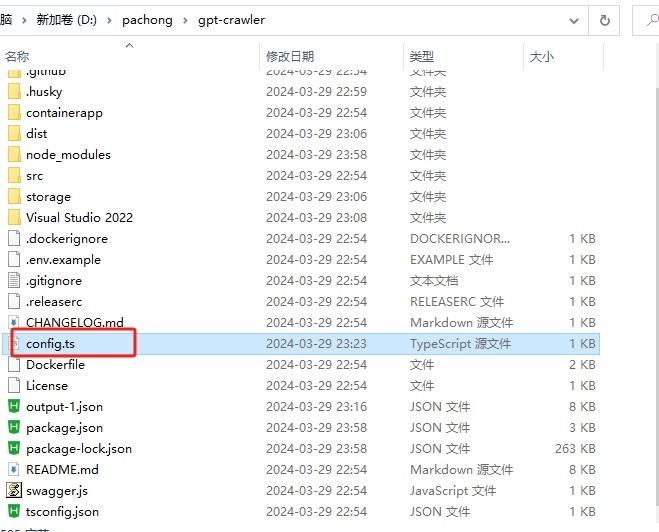

配置抓取文件

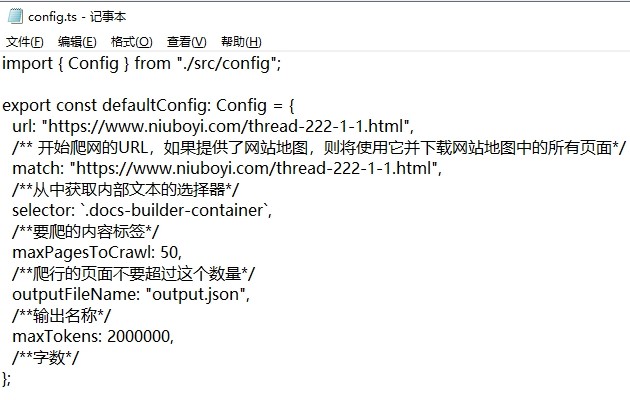

在主程序文件夹里点击config.ts ,用记事本或任意编译软件打开都行。

为了利好新手我就用记事本打开了,看的清晰些。这里面我已经写好了必备的一些参数和对应的中文解释,这些配置代表了我们抓取的网址,抓取的内容包括什么。

代码我放在这里了,需要可以复制。

import { Config } from "./src/config";

export const defaultConfig: Config = {

url: "https://www.niuboyi.com/thread-222-1-1.html",

/** 开始爬网的URL,如果提供了网站地图,则将使用它并下载网站地图中的所有页面*/

match: "https://www.niuboyi.com/thread-222-1-1.html",

/**从中获取内部文本的选择器*/

selector: `.docs-builder-container`,

/**要爬的内容标签*/

maxPagesToCrawl: 50,

/**爬行的页面不要超过这个数量*/

outputFileName: "output.json",

/**输出名称*/

maxTokens: 2000000,

/**字数*/

};

配置好以后我们输入指令 npm start 回车就可以开始抓取了

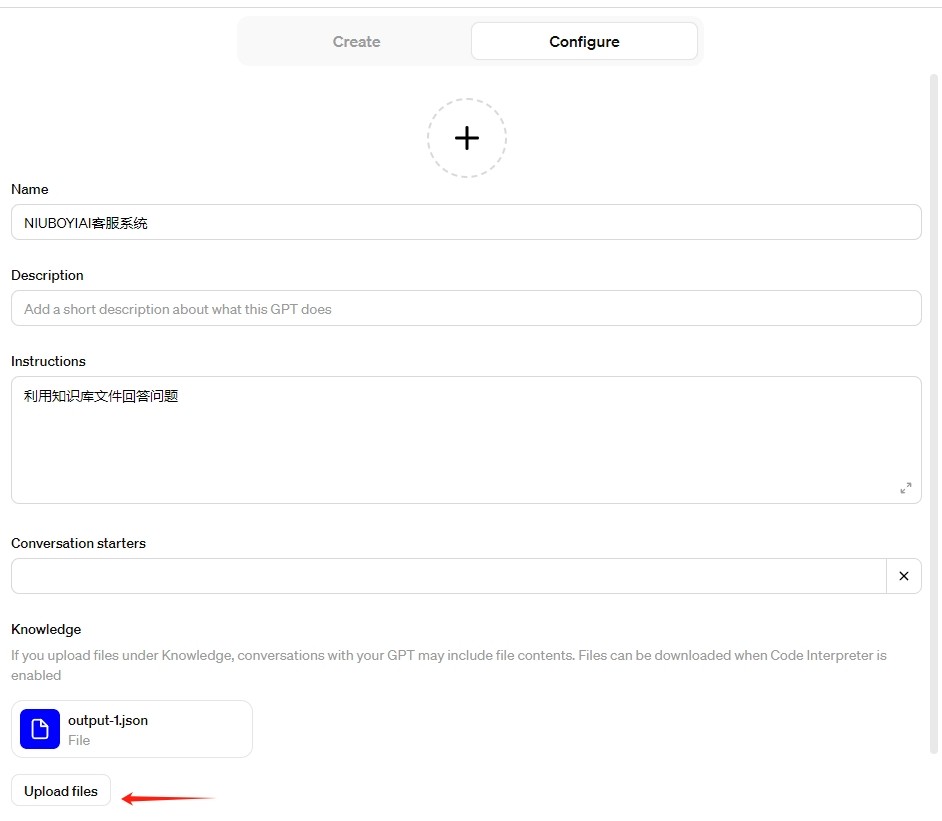

抓取好的文件都在 目录的 output-1.json 这个文件里面,这个文件内容足够多的时候就可以成为你的知识库了。

利用知识库创建专属GPTS

打开gpts 创建界面,https://chat.openai.com/gpts/editor

至此你现在已经拥有了自己的爬虫,可以爬绝大多数的网站了

|  |NIUBOYI

( 京ICP备17025393号 )|网站地图

|NIUBOYI

( 京ICP备17025393号 )|网站地图